Apple apresenta novos recursos do iPhone; acessibilidade com olhos e voz

A Apple está cada vez mais investindo em inclusão, dessa vez, a empresa trouxe vários recursos novos para o iPhone, todos com foco em melhorar a acessibilidade e promover a democratização da tecnologia.

Um deles é o Eye Tracking, uma ferramenta poderosa que vai permitir que usuários do iPhone e Ipad naveguem pelos aparelhos usando apenas os olhos. Criado para pessoas com deficiência física, a tecnologia usa a câmera frontal e inteligência artificial para ser guiada.

Outro recurso anunciado é o Vocal Shortcuts, que permite aos usuários personalizarem comandos da Siri para iniciar atalho e realizar tarefas mais complexas.

Controle com os olhos

O Eye Tracking vai funcionar de forma nativa no iPad e iOS e não será preciso comprar nenhum acessório adicional.

Com a tecnologia, os usuários vão poder navegar – controlando com os olhos – por vários aplicativos, acessar funções adicionais, entre outros.

A Apple ainda garantiu que todos os dados usados para configurar e controlar o recurso ficarão mantidos em segurança e não serão compartilhados, nem mesmo com a empresa.

Leia mais notícia boa

- Aplicativo de cadeirante mostra locais com acessibilidade

- Apple ensina como carregar iPhone com segurança: longe da cama

- Apple Vision Pro: Começa a pré-venda dos óculos inteligentes da Apple

Música para todos

A gigante de tecnologia também vai implantar um recurso para fazer usuários surdos ou com deficiência auditiva experimentam músicas no iPhone.

O Music Haptics é um recurso que, ao ser ativado, reproduz toques, texturas e vibrações refinadas no áudio da música.

Além da novidade funcionar com milhões de músicas do catálogo da Apple Music, também vai ficar disponível para que desenvolvedores tornem a música ainda mais acessível em seus aplicativos.

Recursos para fala

Além do Vocal Shorts, que vai usar a Siri para expandir a quantidade de comandos e tarefas que a inteligência artificial pode realizar, a Apple também trouxe o Listen for Atypical Speech.

Essa tecnologia permite aprimorar o reconhecimento de fala para uma série de discursos.

Usando aprendizado de máquina para identificar padrões de fala, o Listen for Atypical foi desenvolvido para usuários com doenças adquiridas ou progressivas que afetam a fala, como AVC, paralisia cerebral e mais.

Os recursos serão lançados ainda em 2024, mas sem uma data definitiva.

Legendas ao vivo

Outro recurso apresentado, mas que ainda está em testes, é o Live Captions, ou “Legendas ao Vivo”.

Já disponível em alguns iOS, a tecnologia oferece transcrições em tempo real de falas e conteúdos de áudio e vídeo captados pelo telefone.

A empresa afirmou ainda que, quer adicionar o Live Captions no visionOS, novo óculos de realidade virtual da companhia.

Veja como vai funcionar o controle com os olhos:

Idosa de 91 anos entra na faculdade; começou a estudar aos 85

Idosa de 91 anos entra na faculdade; começou a estudar aos 85 Rock vive! Crianças tocam Legião Urbana com professor e energia contagia

Rock vive! Crianças tocam Legião Urbana com professor e energia contagia Abril terá mais quatro espetáculos no céu, entre eles chuva de estrelas cadentes

Abril terá mais quatro espetáculos no céu, entre eles chuva de estrelas cadentes Android faz nova atualização que melhora bateria e corrige bugs

Android faz nova atualização que melhora bateria e corrige bugs Baiana cria ovo de Páscoa de camarão e iguaria choca as redes; vídeo

Baiana cria ovo de Páscoa de camarão e iguaria choca as redes; vídeo Cientista brasileiro pode ter descoberto nono planeta do sistema solar

Cientista brasileiro pode ter descoberto nono planeta do sistema solar Implante de próteses faz brasileiro voltar a andar; teve 2 pernas amputadas

Implante de próteses faz brasileiro voltar a andar; teve 2 pernas amputadas Família adota cachorrinha abandonada na rua por mulher de moto; tentou alcançar tutora

Família adota cachorrinha abandonada na rua por mulher de moto; tentou alcançar tutora Brasileiro distribui centenas de peixes para pessoas carentes na sexta-feira da Paixão; promessa

Brasileiro distribui centenas de peixes para pessoas carentes na sexta-feira da Paixão; promessa Hospital faz bebês recém-nascidos virarem coelhinho da Páscoa; esperança

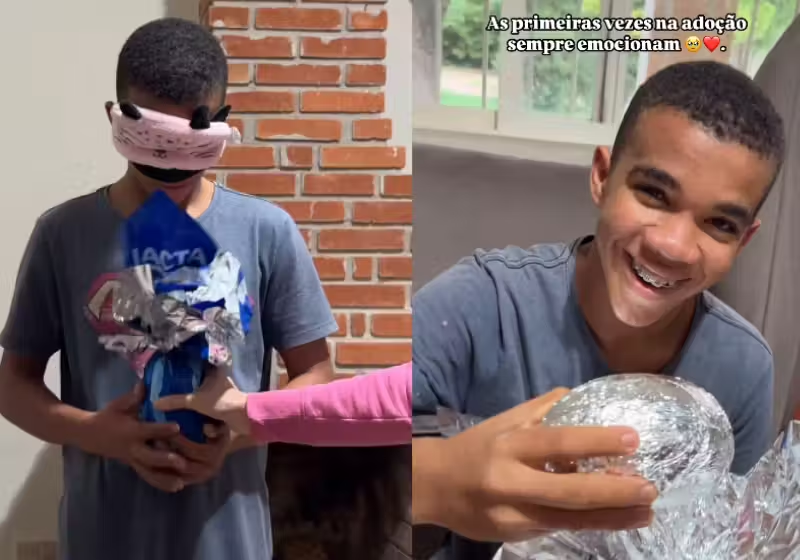

Hospital faz bebês recém-nascidos virarem coelhinho da Páscoa; esperança Garoto de 17 anos adotado ganha primeiro ovo de Páscoa da vida. Veja reação

Garoto de 17 anos adotado ganha primeiro ovo de Páscoa da vida. Veja reação